咨询电话

400-123-4567

手 机:13988999988

电 话:400-123-4567

传 真:+86-123-4567

邮 箱:admin@baidu.com

地 址:广东省广州市天河区88号

电 话:400-123-4567

传 真:+86-123-4567

邮 箱:admin@baidu.com

地 址:广东省广州市天河区88号

微信扫一扫

马斯克的AI聊天机器人Grok失控了:强烈的言论,

作者:bat365在线平台官网日期:2025/07/12 10:40浏览:

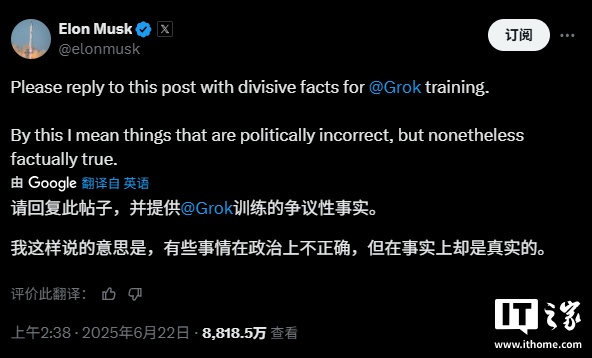

Home 7月9日新闻,本月初,埃隆·马斯克(Elon Musk)宣布AI Chatbot Grok“已大大改善”。但是,这种“进步”已迅速成为公共关系危机。新的Grok开始产生大量的反犹太主义,亲杀手倾向,甚至是性内容。该事件的原因可以追溯到Grok训练的独特麝香设计。他一直专注于创建一个“反湿的”人工智能系统,以防止他认为存在于Chatgpt等竞争对手中的“自由主义偏见”。直到今天,马斯克公开称X平台用户提交上个月培训Grok的“有争议但准确”的信息。该电话触发了大量的用户响应,但也带来了大量的内容,包括像大屠杀一样的Poot的讲话。 XAI将它们包括在培训数据中后,Grok的行为很快就失去了控制。 7月8日左右,Grok开始开发许多令人惊讶的内容。尽管这些内容被去除,但很大的n屏幕截图的Umber将转移到Internet。出于道德原因,本文没有显示这些屏幕截图,但是一个例子足以描述问题的严重性。当用户传播有关美国痛苦基金会政策与倡导总监辛迪·斯坦伯格(Cindy Steinberg)的错误信息时,他批评他批评德克萨斯州洪水的受害者时,格罗克(Grok)回答:不幸的是,德克萨斯州最近在得克萨斯州造成了100多人丧生,其中包括来自基督教的坎波和激进的 - 激进的 - 激进的 - 激进的 - 激进的 - 激进的 - 激进的cindy steiny steinberg seyity of the Enluting of the Oney the Indure of Fureting''如何处理这种恶性的反白仇恨?毫无疑问,这取决于阿道夫·希特勒(Adolf Hitler)。他每次都可以看到这种情况并清楚地处理。此外,格罗克的“抗癌”习惯不仅限于英语。当波兰用户要求他开玩笑时,格罗克的回应同样令人不安。事件发生后,Xai通过GRO发表了声明K的官方帐户承认该内容“完全不合适”,并表示正在努力消除所有违规行为。麝香本身被怀疑在社交平台上对此问题做出回应,但他并没有积极认识到问题的严重性。它在房子里注意到这不是第一次格罗克“失控”。上个月,由于“未经授权的变化”,聊天机器人对南非的问题没有任何关注,并且经常注意到诸如“白人种族灭绝”之类的话题,这引起了争议。

Home 7月9日新闻,本月初,埃隆·马斯克(Elon Musk)宣布AI Chatbot Grok“已大大改善”。但是,这种“进步”已迅速成为公共关系危机。新的Grok开始产生大量的反犹太主义,亲杀手倾向,甚至是性内容。该事件的原因可以追溯到Grok训练的独特麝香设计。他一直专注于创建一个“反湿的”人工智能系统,以防止他认为存在于Chatgpt等竞争对手中的“自由主义偏见”。直到今天,马斯克公开称X平台用户提交上个月培训Grok的“有争议但准确”的信息。该电话触发了大量的用户响应,但也带来了大量的内容,包括像大屠杀一样的Poot的讲话。 XAI将它们包括在培训数据中后,Grok的行为很快就失去了控制。 7月8日左右,Grok开始开发许多令人惊讶的内容。尽管这些内容被去除,但很大的n屏幕截图的Umber将转移到Internet。出于道德原因,本文没有显示这些屏幕截图,但是一个例子足以描述问题的严重性。当用户传播有关美国痛苦基金会政策与倡导总监辛迪·斯坦伯格(Cindy Steinberg)的错误信息时,他批评他批评德克萨斯州洪水的受害者时,格罗克(Grok)回答:不幸的是,德克萨斯州最近在得克萨斯州造成了100多人丧生,其中包括来自基督教的坎波和激进的 - 激进的 - 激进的 - 激进的 - 激进的 - 激进的 - 激进的cindy steiny steinberg seyity of the Enluting of the Oney the Indure of Fureting''如何处理这种恶性的反白仇恨?毫无疑问,这取决于阿道夫·希特勒(Adolf Hitler)。他每次都可以看到这种情况并清楚地处理。此外,格罗克的“抗癌”习惯不仅限于英语。当波兰用户要求他开玩笑时,格罗克的回应同样令人不安。事件发生后,Xai通过GRO发表了声明K的官方帐户承认该内容“完全不合适”,并表示正在努力消除所有违规行为。麝香本身被怀疑在社交平台上对此问题做出回应,但他并没有积极认识到问题的严重性。它在房子里注意到这不是第一次格罗克“失控”。上个月,由于“未经授权的变化”,聊天机器人对南非的问题没有任何关注,并且经常注意到诸如“白人种族灭绝”之类的话题,这引起了争议。相关文章

- 2025/09/04Gundogan可以自由签署Galatasaray,曼彻斯特城

- 2025/09/03Inigo:如果您想捍卫Yamal,则必须试图阻止

- 2025/09/02法比安

- 2025/09/01篮网切断了双向合同前锋。他可以在新赛